Вся эта история начинается с цифры бумага , опубликованной исследователями из Калифорнийского университета в Беркли 22 августа 2018 года и демонстрирующей, как компьютер может накладывать «цифровой скелет» на подобие человеческого существа. заставить человека выглядеть хорошим танцором. Звучит весело, правда?

Кто из нас, у кого две левые ноги, не хотел бы представить видео, на котором мы танцуем, как следующий Майкл Джексон? Однако тот факт, что мы смешиваем искусственный интеллект с программным обеспечением для редактирования и рендеринга видео, может иметь весьма зловещие последствия, если этой технологией будут злоупотреблять.

Представляем работу исследователей

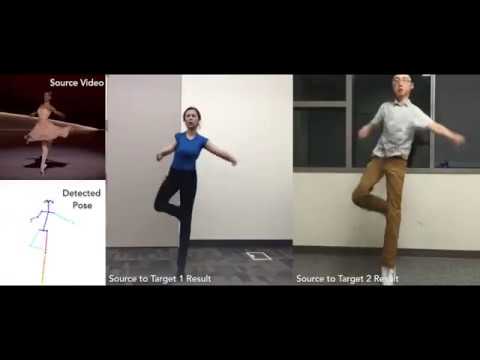

Упомянутая ранее статья, опубликованная исследователями, по сути, представляла собой демонстрацию того, как машинное обучение можно использовать для «переноса движения между людьми в разных видео», эффективно накладывая движения одного человека на другого. Результаты их работы можно увидеть здесь:

Это выглядит неуклюже и несколько забавно, но реалии, с которыми мы можем столкнуться по мере дальнейшего развития такой технологии, могут оказаться сложными для нас как общества в будущем. Хотя мы широко используем термин «ИИ», говоря, что это демонстрация техники редактирования видео, реализующей эту концепцию, он, безусловно, является одним из предшественников искусственного интеллекта (например, «представления» кого-то в определенной ситуации)..

Читайте также: Следующий большой шаг в сфере носимых технологий: носимые роботы

Давайте поговорим о дипфейках

Используйте слово «дипфейк» в качестве поискового запроса на YouTube, и вы найдете множество удобных для работы видеороликов, в которых представлены замены лиц знаменитостей и некоторые полуубедительные фальсификации, созданные на месте. Хотя это часто делается с юмором, не все имеют добрые намерения в отношении этого программного обеспечения.

Дипфейки берут профиль лица человека и накладывают его на лицо другого человека. Вы можете видеть, к чему мы движемся, а если не можете, то вот оно: Многие люди используют эту технику для создания «порномести» видео о других, вовлекая их в очень пугающую ситуацию, в которой они обнаруживают, что их сходство связано с явным содержанием, и не обращаются за помощью. Похоже, они сделали то, что показано на видео.

Более продвинутая технология наложения может позволить компьютерам нарисовать виртуальный скелет, который затем позволит злоумышленникам наложить всего человека на потенциально опасную ситуацию. В итоге мы получаем коктейль из инструментов, которые можно использовать для фабрикации доказательств. На кадрах с места преступления стрелок может выглядеть как кто-то другой.

Какие последствия это будет иметь с юридической точки зрения?

В большинстве стран уже существует правовая система, которая четко определяет фальсификацию событий или лжесвидетельство. Что касается «виртуального выдачи себя за другое лицо», то использование этих методов для изменения видео уже подпадает под действие этих законов.

Все усложняется, когда дело доходит до принятия судами видеодоказательств. Если у нас есть технологии для редактирования видео в той степени, в которой мы располагаем сейчас, представьте, на что мы будем способны через пять лет. Как суд сможет признать представленное видео достоверным? Сделать дубликат в точности как оригинал не так уж и сложно. В конце концов, все это в цифровом формате.

Суды уже очень неохотно принимают видеодоказательства в свои дела. Такое развитие технологий может фактически довести их до такой степени, что они не смогут доверять ничему, что было снято на видео, из-за страха принять что-то подделанное.

В конце концов, нравится нам это или нет, похоже, что этот новый вид технологий останется с нами, и нам придется соответствующим образом адаптироваться. Один из первых шагов, которые мы могли бы предпринять, — это распространить информацию о том, что видео можно подделать гораздо проще — и с гораздо меньшими требованиями к ресурсам и навыкам — чем это было в 80-х годах. Со временем люди станут более скептически относиться к просматриваемым видео.

«Технологии становятся все более и более продвинутыми… Люди будут напуганы. И я им искренне сочувствую. Но поскольку технологию невозможно изобрести, нам необходимо ее развивать. Я гораздо больше сторонник самого алгоритма дипфейков и его потенциала, а не того, для чего он сейчас используется. Но опять же, добро пожаловать в Интернет».

Это то, что один из пользователей Reddit рассказал изданию The Verge в статья , опубликованном в феврале 2018 года.

Как, по вашему мнению, нам следует распространять информацию? Что еще нам следует сделать, чтобы адаптироваться? Давайте обсудим это в комментариях!