За последние несколько лет искусственный интеллект значительно облегчил многие задачи, в том числе и парсинг веб-страниц. В этом списке представлены лучшие инструменты искусственного интеллекта для парсинга веб-страниц, которые каждый может использовать для быстрого и легкого сбора полезных данных практически с любого общедоступного веб-сайта.

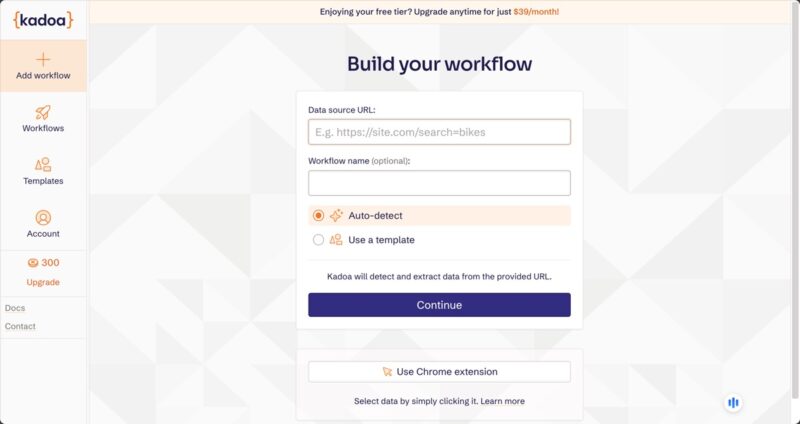

1. Кадоа

Цена : бесплатно, есть премиум-опции

Как человек, потративший немало часов на программирование пользовательских парсеров, я сразу был впечатлен способностью Кадо Contents1. Кадоа

извлекать данные с неструктурированных веб-сайтов с минимальной настройкой. Уже одно это делает Парсинг веб-страниц с помощью ИИ таким замечательным обновлением по сравнению с традиционным парсингом.

Интуитивно понятный интерфейс позволил мне настроить сложные задачи парсинга без написания единой строки кода, что делает его отличным выбором как для новичков, так и для опытных разработчиков, желающих сэкономить время. Существует также расширение Chrome, которое позволяет выбирать данные, просто щелкая по ним.

Во время тестирования я намеренно внес изменения в некоторые целевые веб-сайты, и искусственный интеллект Kadoa автоматически обнаружил эти изменения и адаптировался к ним. Одна только эта функция может сэкономить часы работ по техническому обслуживанию, особенно для крупномасштабных проектов очистки.

2. Бардин

Цена : бесплатно, есть премиум-опции

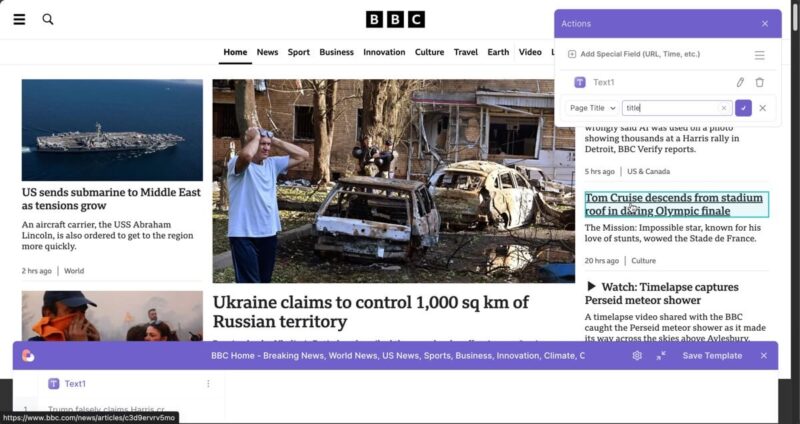

Бардин занял место в этом списке лучших инструментов искусственного интеллекта для парсинга веб-страниц благодаря своим агентам AI-браузера. Эта функция позволяет извлекать информацию с веб-сайтов с помощью команд естественного языка, как это делает человек.

Я использовал агент браузера с искусственным интеллектом для парсинга местного новостного сайта и смог легко настроить автоматизацию, которая собирала данные из результатов поиска Google и автоматически заполняла документ Google Таблицы .

Хотя Bardeen в настоящее время доступен только как расширение Chrome, что может быть ограничено для некоторых, его простота и возможности более чем компенсируют это ограничение.

3. Обзор ИИ

Цена : бесплатно, есть премиум-опции

2. Бардинор ИИ">Обзор ИИ позволяет создавать собственные веб-парсеры, просто взаимодействуя с веб-сайтами, как обычно. Расширение для браузера отслеживает ваши действия и автоматически создает робота, который может повторять эти шаги, что позволяет невероятно легко извлекать данные даже с самых сложных веб-сайтов.

После того как вы соберете нужные данные, вы можете рассчитывать на то, что алгоритмы машинного обучения Browse AI автоматически обнаруживают и исправляют несоответствия в извлеченных данных.

Начать работу с Browse AI очень просто: этот процесс позволяет пользователям начать работу примерно за пять минут. После регистрации бесплатной учетной записи (кредитная карта не требуется), установите расширение для браузера и следуйте пошаговым инструкциям, чтобы научиться обучать собственного помощника по парсингу с помощью искусственного интеллекта.

4. ВебСкрапинг.AI

Цена : личный план — 42 доллара США в месяц, план Plus — 99 долларов США в месяц, план для стартапов — 249 долларов США в месяц.

Веб-скрапинг ИИ предоставляет мощную службу парсинга на основе API, поэтому она лучше подходит разработчикам и технически подкованным пользователям, которым нужен больший контроль над процессами парсинга, не сталкиваясь со сложностями управления прокси и

Веб-скрапинг ИИ . s>13решение.

Поскольку сервис использует настоящие браузеры для отображения страниц, даже многие традиционные меры защиты от парсинга не могут его остановить, а скопированный контент всегда отражает то, что увидит пользователь.

Меня впечатлила возможность задавать WebScraping.AI вопросы о скопированной странице и получать ответы, сгенерированные ИИ. Просто знайте, что стоимость этого инструмента для очистки веб-страниц с использованием искусственного интеллекта измеряется в кредитах. Однако пользователям следует учитывать, что, хотя эта интеграция с искусственным интеллектом является мощной, она потребляет больше кредитов API, чем стандартные запросы на парсинг.

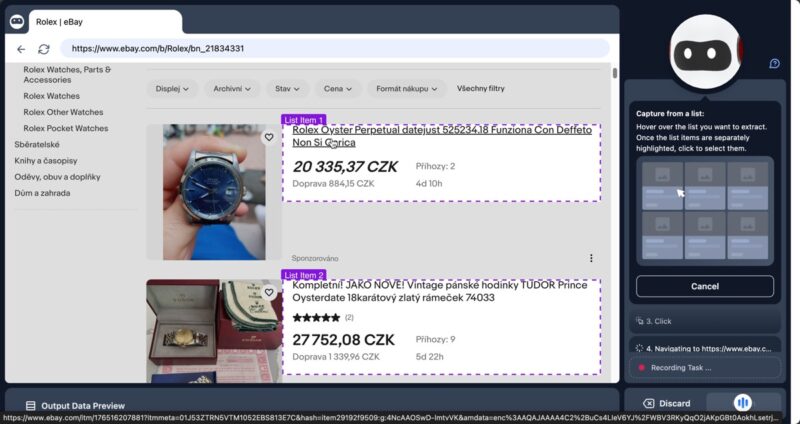

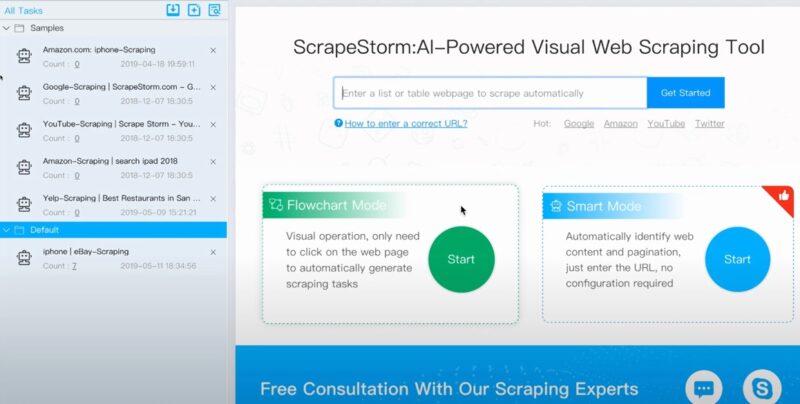

5. ScrapeStorm

Цена : бесплатно, есть премиум-опции

ScrapeStorm выделяется среди других инструментов, предлагая настольное приложение для Windows, Mac и Linux. Этот визуальный инструмент для парсинга веб-страниц, созданный бывшими членами команды Google, сочетает в себе простоту использования Browse AI с мощью и гибкостью WebScraping AI.

Интеллектуальный режим ScrapeStorm использует алгоритмы искусственного интеллекта для автоматического определения данных списка, табличных данных и кнопок нумерации страниц без ручной настройки. Также имеется режим блок-схемы, который позволяет пользователям создавать правила очистки с помощью визуальных операций щелчка мышью.

ScrapeStorm позволяет пользователям экспортировать очищенные данные в различные форматы, включая Excel, CSV, TXT и HTML, а также в такие базы данных,

4. ВебСкрапинг.AI

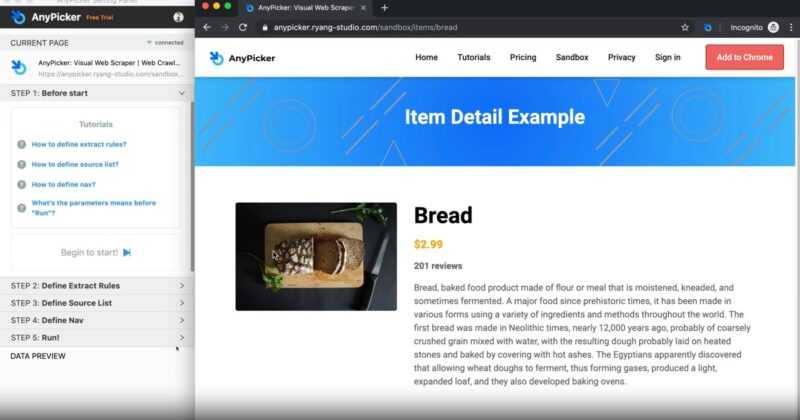

.maketecheasier.com/backup-manage-mysql-databases/" title="MySQL">MySQL , MongoDB и SQL Server. Такая гибкость делает его отличным выбором для пользователей, которым необходимо интегрировать собранные данные в существующие рабочие процессы или базы данных.6. AnyPicker

Цена : бесплатно, есть премиум-опции

AnyPicker – это расширение Chrome, которое позволяет выполнять парсинг веб-страниц с помощью искусственного интеллекта прямо в вашем браузере, и сделать это можно всего за один клик.

<

<Функция интеллектуального обнаружения на базе искусственного интеллекта автоматически определяет закономерности данных на веб-страницах, чтобы вы могли легко выбирать и извлекать необходимую информацию. Веб-сайты, требующие учетные данные для входа, не являются проблемой для AnyPicker. Просто войдите на веб-сайт, который хотите очистить, активируйте AnyPicker и начните извлекать данные.

У меня не возникло проблем с программным обеспечением, но вам следует протестировать инструмент, используя бесплатный план, прежде чем покупать премиум-план.

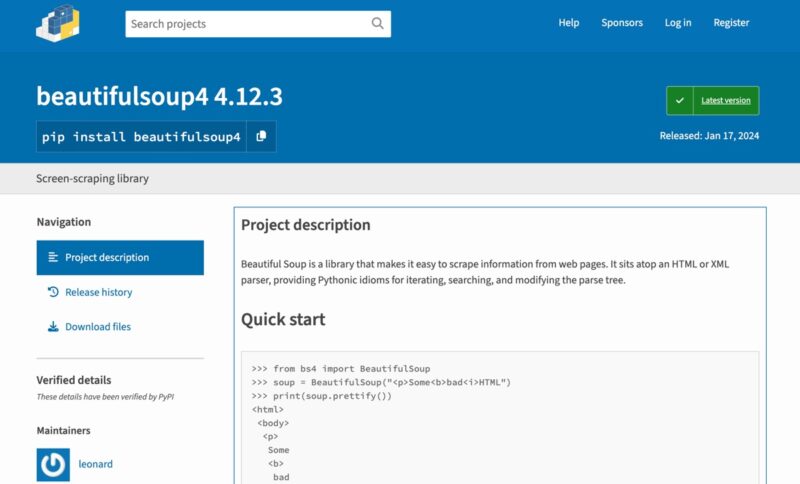

Создайте собственный инструмент для парсинга веб-страниц с использованием искусственного интеллекта

Для тех, у кого есть опыт программирования и кто хочет получить больше контроля над процессом парсинга веб-страниц, можно создать собственный инструмент парсинга веб-страниц на базе искусственного интеллекта, объединив традиционные библиотеки парсинга веб-страниц, такие как Красивый суп , с современными искусственными интеллектами. через API, например из ОпенАИ или антропный .

Основной процесс включает использование Beautiful Soup для сбора необработанных данных с веб-сайтов и последующей отправки этих данных в AI API для об

5. ScrapeStorm

ь в таких задачах, как очистка данных, распознавание объектов, анализ настроений и даже составление сводок очищенного контента.Если вы читаете это, потому что являетесь владельцем веб-сайта и беспокоитесь о защите своего сайта от веб-скрапинга, в этом руководстве описаны несколько решений защитите свой сайт от парсинга ИИ .