Интересно узнать о GPT4All? Я провел неделю, используя это программное обеспечение для запуска нескольких различных моделей больших языков (LLM) локально на своем компьютере, и вот что я узнал.

Что такое GPT4ALL?

GPT4ALL – это э

Contents

Что такое GPT4ALL?

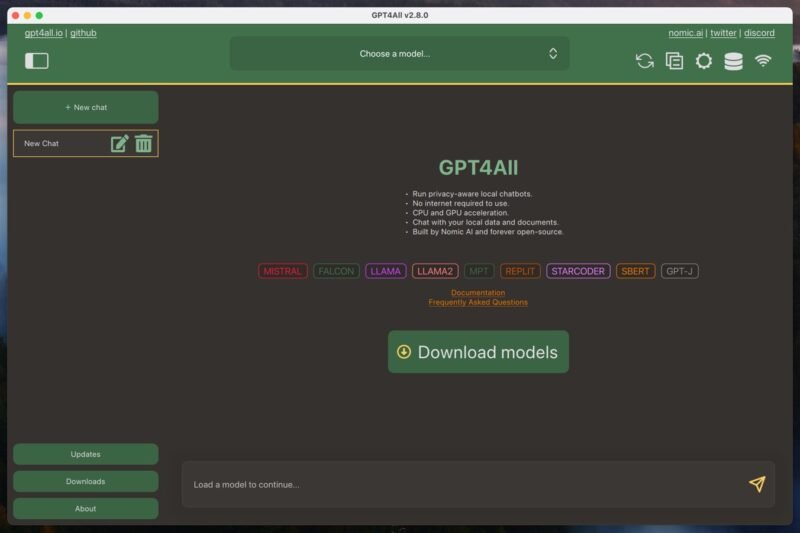

зователям запускать большие языковые модели на своих локальных компьютерах. Эта экосистема состоит из программного обеспечения GPT4ALL, которое представляет собой приложение с открытым исходным кодом для Windows, Mac или Linux, а также больших языковых моделей GPT4ALL. Вы можете загрузить эти модели непосредственно из программного обеспечения GPT4ALL. Обычно их размер составляет от 3 до 8 ГБ.

Одним из ключевых преимуществ GPT4ALL является его способность работать на оборудовании потребительского уровня. Если у вас достаточно мощный процессор с поддержкой инструкций AVX, вы сможете достичь приемлемой производительности. А если у вас еще и современная видеокарта, то можно ожидать еще лучших результатов.

Еще одним преимуществом является ориентированность GPT4ALL на конфиденциальность. Запуская языковые модели локально на вашем компьютере, ваши разговоры и данные могут оставаться конфиденциальными и безопасными. В отличие от облачных сервисов искусственного интеллекта, таких как ЧатGPT , где ваши взаимодействия обрабатываются на удаленных серверах и могут подлежать сбору или мониторингу данных.

Но если вам нравится производительность облачных ИИ-сервисов, вы можете использовать GPT4ALL в качестве локального интерфейса для взаимодействия с ними — все, что вам нужно, это API-ключ .

Установка и настройка GPT4ALL

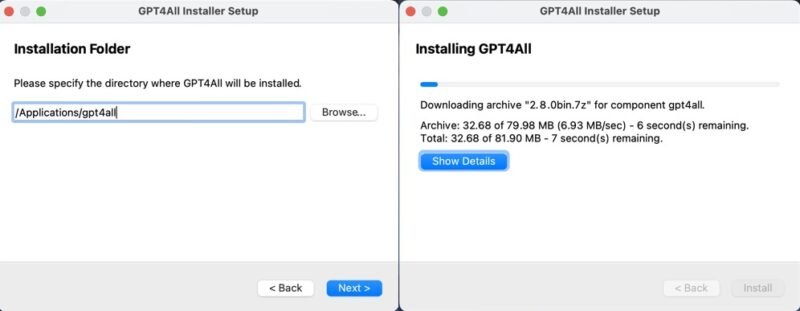

Установка и первоначальная настройка GPT4ALL очень просты независимо от того, используете ли вы Windows, Mac или Linux.

Вам просто нужно загрузить установщик GPT4ALL для вашей операционной системы с веб-сайта GPT4ALL и следовать инструкциям. Независимо от того, используете ли вы Windows, Mac или Linux, этот процесс прост и не займет более нескольких минут.

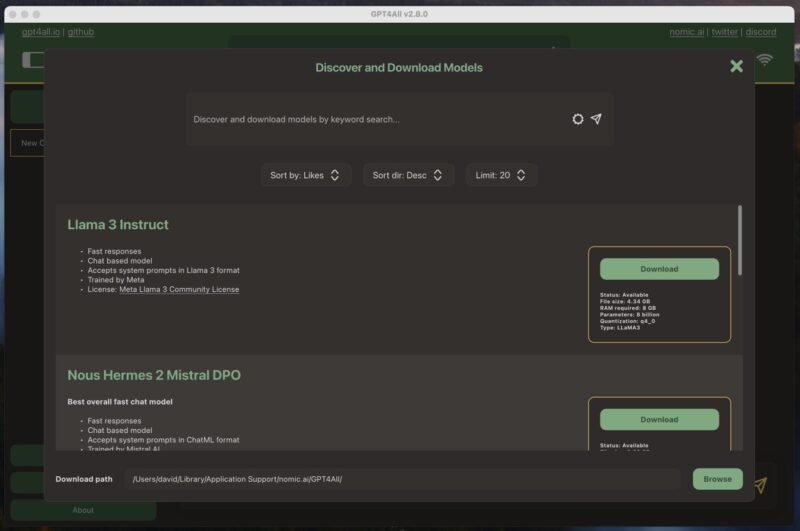

При первом запуске программного обеспечения GPT4ALL вам будет предложено загрузить языковую модель. Я решил остановиться на самой популярной на тот момент модели — Llama 3 Instruct. Размер этой модели составляет чуть больше 4 ГБ, и для ее бесперебойной работы требуется не менее 8 ГБ оперативной памяти.

Загрузить модель так же просто, как установить программное обеспечение. Все, что мне нужно было сделать, это нажать кнопку загрузки рядом с названием модели, а программное обеспечение GPT4ALL позаботилось обо всем остальном.

Как только модель была загруж

Установка и настройка GPT4ALL

ь.Использование GPT4ALL для работы и личной жизни

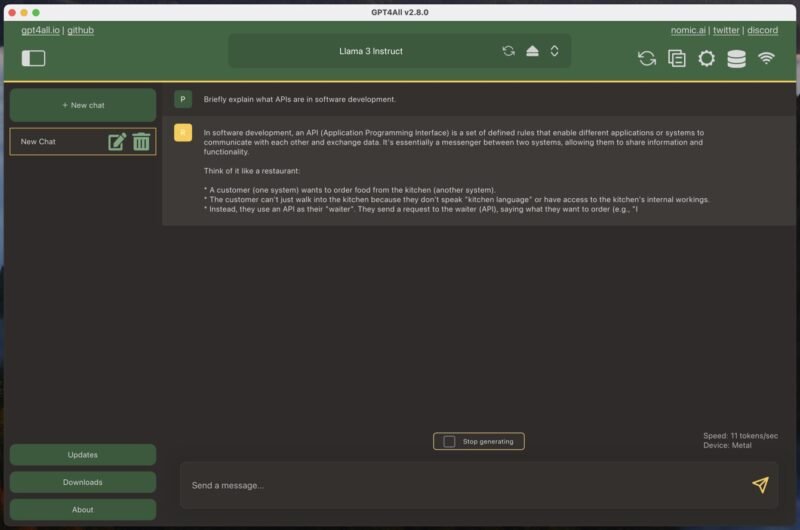

Если вы когда-либо использовали какую-либо модель большого языка в стиле чат-бота, то GPT4ALL будет вам сразу знакома. Единственное отличие состоит в том, что сначала вам необходимо загрузить одну из загруженных моделей, что может занять несколько минут.

Чтобы начать новый чат, просто нажмите большую зеленую кнопку «Новый чат» и введите свое сообщение в текстовое поле. Когда вы отправляете сообщение в GPT4ALL, программа немедленно начинает генерировать ответ. На моем MacBook Air с процессором M1 мне удалось получить около 11 токенов в секунду, используя модель Llama 3 Instruct, что соответствует примерно 90 секундам для генерации 1000 слов. Это довольно впечатляющая цифра, особенно если учесть возраст и доступность моего MacBook Air.

Но скорость — это еще не все. Как насчет производительности?

В целом производительность больших языковых моделей (LLM) хорошо документирована, и вы можете увидеть самые мощные модели на таких сайтах, как Таблица лидеров арены чат-ботов LMSYS . Например, модель Llama 3 Instruct, которую я использовал чаще всего во время тестирования, на данный момент занимает 26-е место среди лучших моделей с результатом 1153 балла. Лучшая модель GPT 4o набрала 1287 баллов.

На практике разница может быть более заметной, чем кажется на первый взгляд. Большие облачные модели обычно намного лучше выполняют сложные инструкции и работают с гораздо более широким контекстом. Например, Gemini Advanced имеет контекстное окно из 32 тысяч токенов, тогда как Llama 3 Instruct по умолчанию имеет только 2048 токенов в GPT4ALL — хотя вы можете увеличить его вручную, если у вас мощный компьютер.

Это самые большие недостатки по сравнению с облачными моделями. Однако наиболее значительными плюсами являются конфиденциальность и доступность. С GPT4ALL вы можете быть уверены, что ваши разговоры и данные останутся конфиденциальными и безопасными на вашем локальном компьютере. Вам не нужно беспокоиться о том, что ваши взаимодействия обрабатываются на удаленных серверах или могут стать объектом сбора или мониторинга данных третьими лицами.

Более того, поскольку вы используете модель локально, на вас не влияют какие-либо недостатки третьих сторон. Например, ChatGPT довольно часто не работает (можно посмотреть его текущий статус здесь ), и один несвоевременный период простоя может серьезно нарушить ваш рабочий процесс и заставить вас пожалеть о своей подписке. Этого не может случиться с GPT4ALL, особенно если вы устанавливаете его более чем на один компьютер, чтобы учесть непредвиденный сбой оборудования.

Полное использование GPT4ALL

Чтобы максимально эффективно использовать GPT4ALL, вам следует сделать три основные вещи:

- Используйте лучшее из доступных LLM. Модели постоянно развиваются быстрыми темпами, поэтому важно быть в курсе последних событий. Следите за списками лидеров LLM, такими как вышеупомянутая LMSYS Chatbot Arena Leaderboard, и присоединяйтесь к сообществам, таким как р/LocalLLM , чтобы быть в курсе лучших доступных моделей.

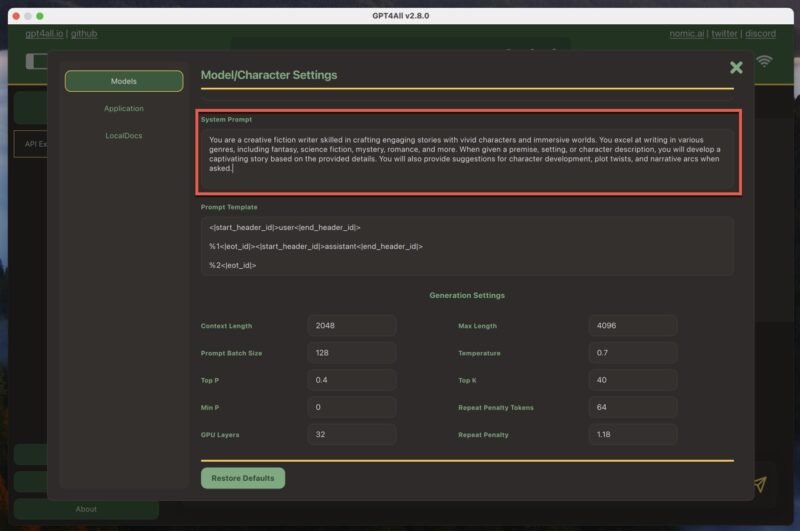

- Настройте системное приглашение. Системное приглашение задает контекст для ответов ИИ. В GPT4ALL его можно найти, перейдя в Настройки модели ->Системная подсказка t. Настройте подсказку системы в соответствии со своими потребностями, предоставив четкие инструкции или указания, которым должен следовать ИИ. Это поможет вам получать более точные и релевантные ответы.

- Задавайте правильные вопросы. Быстрое проектирование — ключ к получению наилучших результатов от GPT4ALL. Будьте конкретны и ясны в своих вопросах и предоставьте достаточно контекста, чтобы ИИ мог генерировать полезные ответы. Поэкспериментируйте с разными форматами вопросов и формулировками, чтобы найти то, что лучше всего подходит для вашего случая.

Следуя этим трем передовым практикам, я смог сделать GPT4ALL ценным инструментом в своем наборе инструментов для письма и отличной альтернативой облачным моделям искусственного интеллекта.

Стоит отметить, что помимо генерации текста также можно локально генерировать изображения ИИ с помощью таких инструментов, как Stable Diffusion. Если вы заинтересованы в изучении мира создания локальных изображений с помощью ИИ, обязательно ознакомьтесь с нашим руководством на странице как использовать Stable Diffusion для создания изображений, сгенерированных искусственным интеллектом .

Изображение предоставлено: DALL-E. Все скриншоты Дэвида Морело