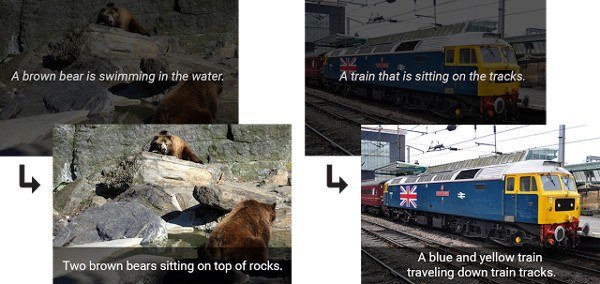

Не секрет, что в последние годы Google становится более активным в исследованиях, особенно после он значительно реорганизовался в 2015 году. 22 сентября 2016 года компания объявила о выпуске с открытым исходным кодом программного обеспечения, может обнаружить объекты и настройку изображения автоматически создать описывающую его подпись. Конечно, он не обладает тем же уровнем творчества, что и люди в создании прозы внутри подписей, но кодировщик изображений, также известный как Inception V3, должен был привлечь внимание по причинам, выходящим за рамки поверхностного «посмотрите на подписи, это так». может сделать» мотив. На самом деле подобное программное обеспечение может стать ступенькой к чему-то большему на пути к более совершенному искусственному интеллекту.

Глаза видят, но интеллект «воспринимает»

Искусственное зрение существует уже более века. Все, что имеет камеру, может видеть. Это очень простая вещь. Но даже слепой может превзойти понимание камерой того, на что она смотрит. До недавнего времени компьютеры не могли легко и точно называть объекты, найденные на картинках, без очень конкретных параметров. По-настоящему сказать, что искусственный объект обладает «видением», означало бы, что он, по крайней мере, обладает конкретной способностью определять на чтоон смотрит, а не просто смотреть на него, не собирая никакого контекста. Таким образом, устройство потенциально могло бы реагировать на окружающую среду, основываясь на зрении, точно так же, как это делаем мы. Восприятие является абсолютной необходимостью. Без него все наши чувства бесполезны.

Восприятие посредством автоматических подписей к изображениям

Хотя мы обычно считаем, что каждая картинка стоит тысячи слов, Inception V3 не обязательно разделяет это мнение. Программное обеспечение для автоматического создания титров мало что может сказать о том, что оно видит, но оно, по крайней мере, имеет базовое конкретное представление о том, что содержится в представленном ему кадре.

Благодаря этой элементарной информации мы сделали шаг к тому, чтобы программное обеспечение могло понимать визуальные стимулы. Предоставление роботу такой силы позволило бы ему реагировать на такие раздражители, доведя его интеллект до уровня большинства простых водных животных. Это может показаться не таким уж большим достижением, но если вы посмотрите на то, как роботы ведут себя прямо сейчас (при тестировании за пределами их строго ограничительных параметров), вы обнаружите, что это был бы настоящий скачок в интеллекте по сравнению с амебным способом, при котором они могут воспринимать свое окружение.

Что это значит для ИИ (и почему он далек от совершенства)

Тот факт, что теперь у нас есть программное обеспечение, которое (с точностью 93 %) может создавать подписи к изображениям, означает, что мы в некоторой степени преодолели препятствие, мешающее компьютерам понимать окружающую среду. Конечно, это не значит, что мы почти закончили в этом отделе. Также стоит отметить, что Inception V3 со временем обучался людьми и использует «изученную» информацию для расшифровки других изображений. Чтобы иметь истинное понимание окружающей среды, необходимо достичь более абстрактного уровня восприятия. Злится ли человек на изображении? Два человека ругаются? О чем плачет женщина на скамейке?

Вышеупомянутые вопросы отражают те вопросы, которые мы задаем себе, когда сталкиваемся с другими людьми. Это своего рода абстрактное исследование, которое требует от нас экстраполяции большего количества информации, чем то, что могут сделать глупости с подписями к изображениям. Давайте не будем забывать, что вишенкой на торте мы любим называть эмоциональную (или «иррациональную») реакцию на то, что мы видим. Вот почему мы считаем цветы красивыми, канализацию – отвратительной, а картошку фри – вкусной. Нам все еще интересно, сможем ли мы когда-нибудь достичь этого на машинном уровне без жесткого кодирования. Правда в том, что такого рода «человеческий» феномен, скорее всего, невозможен без ограничительного программирования. Конечно, это не значит, что мы не перестанем пытаться. В конце концов, мы люди.

Думаете ли вы, что наши роботы-повелители когда-нибудь научатся ценить сложность лепестка розы под микроскопом? Расскажите нам в комментариях!